Wie nutzt man KI-Stimmen für Podcasts?

Transcribe, Translate & Summarize in Seconds

Transcribe, Translate & Summarize in Seconds

KI-Stimmen sind synthetische Sprachausgaben, die aus geschriebenem Text mithilfe von KI-Stimmengeneratoren erzeugt werden. In der Podcast-Produktion ermöglichen KI-Stimmengeneratoren den Erstellern, Skripte direkt in gesprochenes Audio umzuwandeln, ohne Mikrofon oder Aufnahmesoftware zu verwenden. Der KI-Stimmen-Generierungsprozess beginnt mit der Vorbereitung eines Textskripts, der Auswahl einer digitalen Stimme aus der Bibliothek der KI-Stimmengeneratoren und dem Export der Audiodatei zur Bearbeitung oder sofortigen Verwendung.

Die KI-Stimmengenerierung hilft, einen einheitlichen Stimmton über alle Episoden hinweg beizubehalten, unterstützt Anpassungen in Tempo und Aussprache und bietet Zugang zu mehreren Sprachen und Akzenten über eine einzige Oberfläche. Podcaster nutzen KI-Stimmtools, um Produktionszeiten zu verkürzen, die Sprachausgabe präzise zu steuern und die Gesamtproduktionskosten zu senken.

Da der globale Podcast-Markt laut Fortune Business Insights weiterhin rapide wächst, setzen Ersteller zunehmend auf KI-Stimmtools, um die Nachfrage nach skalierbarer, effizienter Inhaltsproduktion zu erfüllen.

Hier ist eine kurze Liste, die die fünf Hauptschritte zur Nutzung von KI-Stimmen für Podcast-Produktion zusammenfasst.

- Wählen Sie einen KI-Stimmengenerator: Wählen Sie einen KI-Stimmengenerator, der natürlich klingende Stimmen und Anpassungsoptionen bietet.

- Schreiben Sie ein Podcast-Skript: Bereiten Sie ein klares, strukturiertes Skript vor, das zum Podcast-Format und -Ton passt.

- Weisen Sie Stimmen zu und passen Sie Einstellungen an: Wählen Sie Stimmen für verschiedene Teile oder Charaktere und modifizieren Sie bei Bedarf Geschwindigkeit, Tonhöhe oder Emotion.

- Exportieren und speichern Sie die Audiodatei: Laden Sie die fertige Sprachausgabe in einem kompatiblen Audioformat wie MP3 oder WAV herunter.

- Veröffentlichen Sie die Episode: Laden Sie die Audiodatei auf eine Podcast-Hosting-Plattform oder in eine Bearbeitungssoftware zur Verbreitung hoch.

1. Wählen Sie einen KI-Stimmengenerator

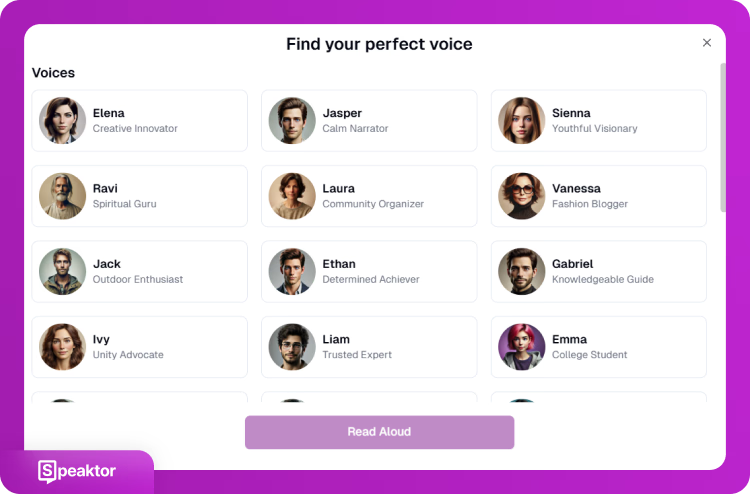

Die Auswahl eines KI-Stimmengenerators ist der erste Schritt in der Podcast-Produktion mit synthetischer Erzählung. Ein KI-Stimmengenerator muss Text mit hoher Klarheit und natürlichem Tempo in Sprache umwandeln. Der ausgewählte KI-Stimmengenerator sollte mehrere Stimmoptionen bieten, einschließlich Variationen in Akzent, Geschlecht und Tonfall, um verschiedenen Podcast-Formaten gerecht zu werden.

Zu den wichtigsten Funktionen gehören Stimmanpassungseinstellungen (Geschwindigkeit, Tonhöhe, Betonung), Unterstützung für mehrere Sprachen und die Möglichkeit, verschiedenen Abschnitten unterschiedliche Stimmen zuzuweisen. Einige Dienste wie Speaktor, Speechify und Murf AI bieten Stimmklonen an, wodurch Ersteller bestimmte Stimmstile für Markenkonsistenz replizieren können.

Speaktor, ElevenLabs, Speechify und Murf AI unterscheiden sich in Stimmqualität, Kontrollfunktionen und Exportformaten. Podcaster wählen basierend auf Projektanforderungen aus, wie mehrsprachige Unterstützung, Kontrolle des emotionalen Tons oder Integration in Bearbeitungsabläufe. Da eMarketer ein kontinuierliches Wachstum der globalen Podcast-Hörerschaft prognostiziert, wird die Auswahl eines KI-Stimmengenerators, der die Publikumserweiterung unterstützt, immer wichtiger.

Die folgenden KI-Stimmengeneratoren stechen unter den verfügbaren Optionen für die Podcast-Produktion hervor.

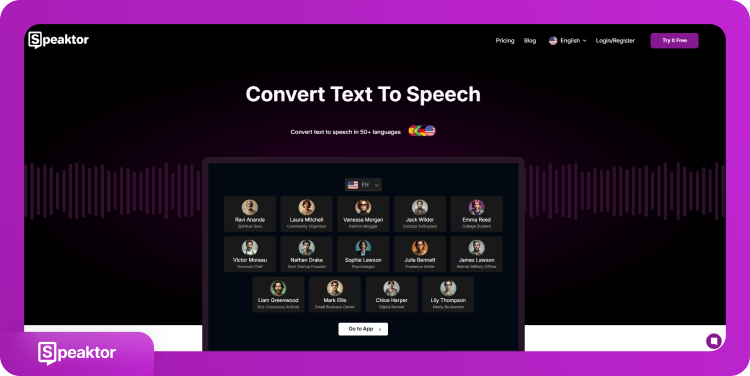

- Speaktor: Speaktor erzeugt KI-Sprachausgaben in über 50 Sprachen und mehr als 15 Tonlagen mit hoher Genauigkeit.

- ElevenLabs: ElevenLabs unterstützt über 300 Stimmen und eine intuitive Benutzeroberfläche, um den Podcast-Erstellungsprozess zu optimieren.

- Speechify: Funktionen wie sofortige KI-Zusammenfassungen, Stimmklonen und OCR-Scanning können Podcastern zugutekommen.

- Murf AI: Murf bietet hochwertige Stimmen und unterstützt über 120 Stimmen in mehr als 20 Sprachen.

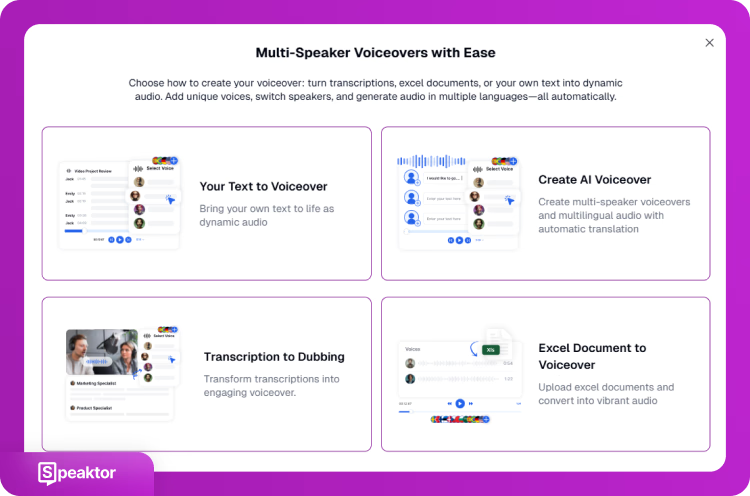

1.1 Speaktor

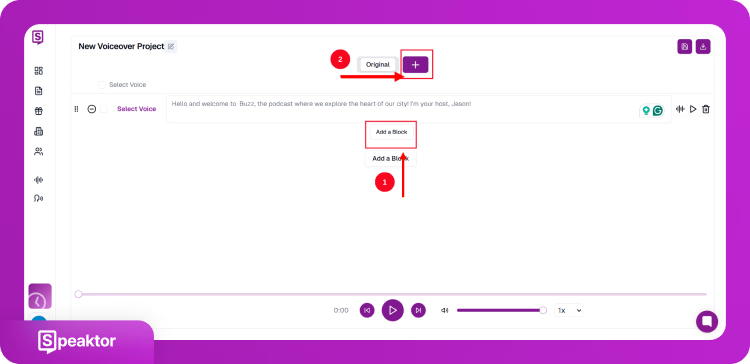

Speaktor ist ein browserbasierter TTS-Generator, der für schnelle Sprachausgabe in über 50 Sprachen konzipiert ist. Speaktor bietet mehrere Stimmtöne, die für verschiedene Inhaltsformate geeignet sind, darunter formelle, lockere und charakterbasierte Erzählung. Über das Podcasting hinaus unterstützt Speaktor verschiedene Anwendungsfälle in unterschiedlichen Branchen und Inhaltstypen. Benutzer können Einstellungen wie Tonhöhe, Tempo und strategische Pausen anwenden, um Rhythmus und Klarheit in Podcast-Audio zu verbessern.

Die Benutzeroberfläche von Spektor ermöglicht es Benutzern, verschiedenen Dialogblöcken unterschiedliche Stimmen zuzuweisen, was sie für Podcast-Formate mit mehreren Stimmen nützlich macht. Speaktor unterstützt auch Echtzeit-Skriptbearbeitung und Export in WAV- und MP3-Formaten. Für Ersteller, die ihren gesamten Workflow optimieren möchten, bietet Speaktor umfassende Text-zu-Podcast-Konvertierung, die den gesamten Produktionsprozess vom Skript bis zur fertigen Audiodatei vereinfacht.

Vorteile:

- Große Auswahl an Sprachen und Tonarten

- Intuitive Mehrfachstimmen-Bearbeitung

- Klare Sprachausgabe mit Anpassungsmöglichkeiten

Nachteile

- Eingeschränkte Kontrolle über emotionale Ausdrucksweise

1.2 ElevenLabs

ElevenLabs bietet über 300 Stimmmodelle und unterstützt Stimmklonen für fortgeschrittene Podcast-Anwendungsfälle. ElevenLabs ist spezialisiert auf die Erzeugung von ausdrucksstarkem Audio mit Tonvariationen und präzisem Tempo. Die Stärke von ElevenLabs liegt in der emotionalen Ausdrucksweise, was es ideal für Storytelling und dramatische Dialoge macht.

ElevenLabs bietet eine Stimm-Design-Oberfläche, mit der Benutzer Stimmcharakteristiken fein abstimmen oder echte menschliche Stimmen nachbilden können. Die ElevenLabs-Benutzeroberfläche unterstützt mehrsprachige Ausgabe, obwohl dem Generator die vollständige Kontrolle über das Timing zwischen Wörtern und detaillierte Betonungseinstellungen fehlt.

Vorteile:

- Hoher emotionaler Realismus

- Umfangreiche Stimmbibliothek

- Stimmklonfunktionen

Nachteile:

- Keine manuelle Pausen- oder Tonhöhensteuerung

- Leichte Lernkurve für Anpassungen

1.3 Speechify

Speechify bietet eine große Auswahl an Stimmoptionen in über 60 Sprachen. Speechify enthält OCR-Scanning, KI-generierte Zusammenfassungen und Stimmklonen. Die integrierten Tools von Speechify unterstützen Podcaster, die visuelle Inhalte in gesprochenen Text umwandeln oder Skripte effizient wiederverwenden müssen.

Die geräteübergreifende Kompatibilität von Speechify gewährleistet die Abstimmung mit mobilen und Desktop-Workflows. Während Speechify gut für Erzählungen und Zusammenfassungen geeignet ist, klingen einige Stimmen oft künstlich, besonders bei längeren Audioausgaben oder komplexen emotionalen Szenen.

Vorteile:

- Stimmklonen und Zusammenfassungstools

- Kompatibel mit allen wichtigen Plattformen

- OCR und visuell-zu-audio Eingabe

Nachteile:

- Einige Stimmen klingen synthetisch

- Begrenzte Bearbeitungsflexibilität

1.4 Murf AI

Murf AI bietet präzise TTS-Konvertierung mit über 120 Stimmen in mehr als 20 Sprachen. Murf AI ermöglicht die Kontrolle über Geschwindigkeit, Intonation und Sprachpausen, was das Tool sowohl für Solo- als auch für Mehrpersonen-Podcasts geeignet macht. Die Benutzeroberfläche ist auf Benutzerfreundlichkeit optimiert und erfordert minimale technische Vorkenntnisse.

Murf AI bietet Stimmkennzeichnung für die Zuweisung von Rollen in Skripten mit mehreren Sprechern und unterstützt den Export in verschiedenen Formaten. Die Haupteinschränkung von Murf liegt in gelegentlichen Fehlaussprachen, besonders bei ungewöhnlichen Wörtern oder Namen.

Vorteile:

- Schnelle Stimmzuweisung für Skripte mit mehreren Rollen

- Gute Tonkontrolle und Tempo

- Benutzerfreundliche Oberfläche

Nachteile:

- Kann nicht-standardmäßige Wörter falsch aussprechen

- Weniger Stimmen im Vergleich zu größeren Bibliotheken

2. Ein Podcast-Skript schreiben

KI-Stimmen für Podcast verlassen sich vollständig auf das geschriebene Skript, um Audio zu generieren. Die Ausgabe spiegelt die exakten Wörter, Satzstrukturen, Zeichensetzung und Formatierung wider, die in den ausgewählten KI-Stimmgenerator eingegeben wurden. Ein klares, strukturiertes Skript hilft, das Engagement der Zuhörer aufrechtzuerhalten und verhindert roboterhafte oder unzusammenhängende Wiedergabe.

Tonfall bezieht sich auf den allgemeinen Sprachstil, wie formal, locker, lehrreich oder erzählerisch. Das Tempo steuert, wie schnell oder langsam die Sprache fließt. Die Skriptstruktur bezieht sich darauf, wie Inhalte in Segmente unterteilt werden, einschließlich Einleitungen, Übergänge und Abschlüsse. Tonfall, Tempo und Segmentstruktur müssen durch Satzwahl, Zeichensetzung und Formatierung gesteuert werden.

Um ein Podcast-Skript für KI-Stimmen für Podcast vorzubereiten, befolgen Sie die nachstehenden Richtlinien.

- Format definieren: Identifizieren Sie, ob die Episode ein Monolog, Dialog, Interview oder eine erzählerische Geschichte ist. Strukturieren Sie das Skript basierend auf diesem Format in klare Abschnitte.

- Verwenden Sie kurze, direkte Sätze: Vermeiden Sie lange oder zusammengesetzte Satzstrukturen. Verwenden Sie klare, vollständige Sätze für eine einfachere KI-Verarbeitung.

- Fügen Sie Interpunktion für den Rhythmus ein: Verwenden Sie Kommas, Punkte und Auslassungszeichen, um den Sprechrhythmus zu steuern. Fügen Sie Zeilenumbrüche zwischen Absätzen ein, um Pausen anzuzeigen.

- Fügen Sie Kontraktionen ein, wo angemessen: Schreiben Sie natürlich konversationelle Phrasen (z.B. „du bist" statt „du bist es"), wenn der Ton informell ist.

- Fügen Sie Sprecherkennzeichnungen für Multi-Voice-Setups ein: Kennzeichnen Sie jede Sprechzeile deutlich, um sie später einer bestimmten KI-Stimme zuzuweisen.

- Markieren Sie Ausspracheanmerkungen: Verwenden Sie Klammern für phonetische Schreibweisen oder Betonungshinweise, wenn das TTS-Tool manuelle Eingabesteuerung ermöglicht.

- Vermeiden Sie vage oder Füllwörter: KI-Stimmen interpretieren exakte Eingaben. Eliminieren Sie unnötige Modifikatoren oder abstrakte Ausdrücke, die die Wiedergabe verzerren könnten.

3. Stimmen zuweisen und Einstellungen anpassen

Sobald das Skript fertig ist, besteht der nächste Schritt darin, Stimmen zuzuweisen und Wiedergabeeinstellungen zu konfigurieren. Stimm- und Wiedergabeeinstellungen prägen, wie der Inhalt klingt, ob der Ton dynamisch, formell, konversationell oder charakterbasiert ist. Die Stimmzuweisung wird besonders wichtig für Episoden mit mehreren Sprechern oder Inhalte, die Dialoge oder Erzählwechsel beinhalten.

Beginnen Sie damit, verschiedenen Sprechern oder Abschnitten unterschiedliche Stimmen zuzuweisen. Die meisten KI-Stimmen für Podcast-Tools ermöglichen es Benutzern, aus einem Menü von Stimmmodellen auszuwählen und diese auf bestimmte Textblöcke anzuwenden. Podcaster wählen Stimmen basierend auf der Rolle jedes Sprechers; langsamere, tiefere Stimmen eignen sich für autoritative Teile, während leichtere Töne besser für lockere oder responsive Rollen funktionieren.

Verwenden Sie die folgenden Anpassungen, um die Stimmwiedergabe zu steuern.

- Ändern Sie die Geschwindigkeit, um das Tempo zu kontrollieren. Langsamere Geschwindigkeiten eignen sich gut für ernste oder technische Inhalte, während schnellere Wiedergabe zu energischen oder lockeren Themen passt.

- Passen Sie die Tonhöhe an, um Charaktere zu unterscheiden oder den Ton für verschiedene Segmente zu ändern. Eine etwas höhere Tonlage kann Jugend oder Dringlichkeit vermitteln; eine tiefere kann bedachter klingen.

- Wenden Sie emotionale Voreinstellungen an, wenn das Tool dies zulässt (z.B. ruhig, aufgeregt, wütend). Dies verleiht der Wiedergabe mehr Nuancen, besonders in Erzählungen oder dramatisierten Segmenten.

4. Audio exportieren und speichern

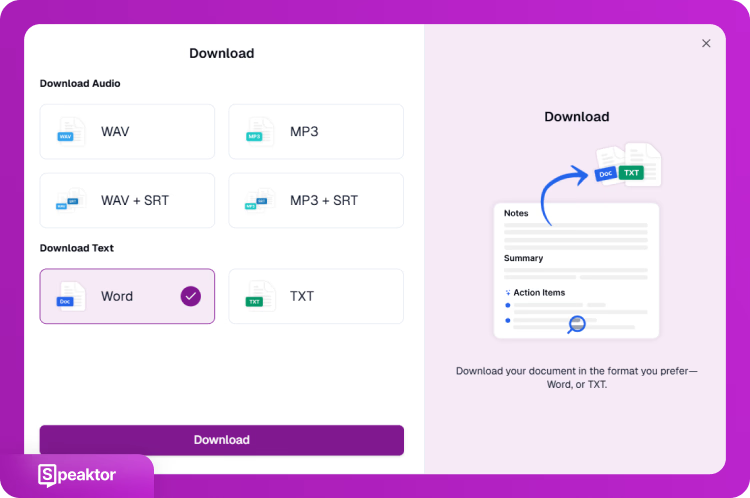

Nach der Zuweisung von Stimmen und der Einstellung der Wiedergabeparameter besteht die letzte Aufgabe darin, die KI-generierte Sprachausgabe in eine verwendbare Audiodatei zu exportieren. Die exportierte Sprachausgabe wird zur Grundlage für die Veröffentlichung oder weitere Bearbeitung. Die meisten KI-Stimmen für Podcast-Generatoren bieten Optionen zum Herunterladen der Ausgabe in verschiedenen Formaten, je nach beabsichtigter Verwendung. Für professionelle Ergebnisse verwenden Sie Adobe Podcast Audiofilter, um die Klangqualität nach dem Export zu verbessern.

Fünf Exportschritte umfassen Folgendes.

- Dateiformat auswählen: Wählen Sie MP3 für allgemeine Verwendung oder WAV für hochwertige Bearbeitung. MP3 ist komprimiert und eignet sich gut für direkte Uploads. WAV bewahrt die volle Klangqualität für fortgeschrittene Nachbearbeitung.

- Audioqualitätseinstellungen anpassen: Stellen Sie die Bitrate oder Abtastrate nach Bedarf ein. Höhere Einstellungen erzeugen klareren Ton, erhöhen aber die Dateigröße.

- Audiodatei herunterladen: Klicken Sie auf die Export- oder Download-Schaltfläche. Speichern Sie die Datei auf Ihrem Gerät oder einer Cloud-Plattform zur Aufbewahrung und zum Teilen.

- Skript exportieren (optional): Speichern Sie das Originalskript im TXT- oder DOCX-Format, wenn das Tool dies anbietet. Dies hilft bei der Archivierung oder Erstellung von Shownotes und Transkripten.

- Wiedergabe überprüfen: Hören Sie sich die exportierte Audiodatei mit einem Media Player an. Überprüfen Sie Aussprache, Tempo, Stimmwechsel und Pausengenauigkeit. Bei Bedarf neu bearbeiten und erneut exportieren.

5. Optimierung für mehrsprachige und emotionale Wiedergabe

Die Verbesserung der Podcast-Wiedergabe mit mehrsprachiger Unterstützung und emotionalen Stimmeinstellungen erweitert die Reichweite des Publikums und verbessert das Engagement. Viele KI-Stimmen für Podcast-Dienste bieten Sprachenwechsel und Emotionsvoreinstellungen an, um dem Ton des Skripts oder der Zielgruppe zu entsprechen.

Um Inhalte für verschiedene Sprachen vorzubereiten, übersetzen Sie das Skript mit einem professionellen Übersetzungsprogramm oder einem integrierten Sprachmodul. Podcaster wählen eine Stimme, die zur Sprache und zum Ton passt. Stellen Sie sicher, dass die ausgewählte Stimme die richtige Aussprache und den richtigen Rhythmus für diese Sprache verwendet, und überprüfen Sie kulturelle Formulierungen, um die Klarheit zu erhalten. Laut Statista bleiben Bedenken bezüglich KI-Technologie bedeutend, wobei 74% der US-Erwachsenen Bedenken zum Datenschutz äußern und 63% sich Sorgen über die Transparenz beim Training von KI-Modellen machen. Transparenz bei der Nutzung von KI hilft, Vertrauen beim Publikum aufzubauen und diese berechtigten Bedenken anzusprechen.

Die folgenden Anpassungen steuern, wie die KI-Stimme Emotionen ausdrückt und Inhalte in verschiedenen Sprachen liefert.

- Wählen Sie eine Stimme mit Emotions-Voreinstellungen wie neutral, aufgeregt oder ernst.

- Passen Sie den emotionalen Ton an den Inhaltstyp an (z.B. aufgeregt für Ankündigungen, ruhig für Anweisungen).

- Stimmen Sie Tonhöhe und Tempo ab, um emotionalen Realismus zu unterstützen.

Das Folgende hilft, Konsistenz und Klarheit bei der Produktion von Podcast-Audio für internationale Zuhörer zu bewahren.

- Wählen Sie mehrsprachige Stimmen, die zu regionalen Dialekten passen.

- Verwenden Sie die gleiche Struktur und Zeitplanung in allen Versionen, um Konsistenz zu gewährleisten.

- Validieren Sie die Audioausgabe wenn möglich mit Muttersprachlern.

Fazit

KI-Stimmen für Podcast transformieren die Podcast-Produktion, indem sie die Erstellung von professioneller Audioqualität zugänglich und effizient machen. Der Erfolg hängt von der Auswahl der richtigen Tools wie Speaktor, ElevenLabs oder Murf AI, der Vorbereitung gut strukturierter Skripte und der Konfiguration geeigneter Spracheinstellungen ab. Während beim Publikum Bedenken bezüglich KI bestehen, schafft transparente Kommunikation über deren Nutzung Vertrauen und hilft Erstellern, diese leistungsstarken Tools zu nutzen, um den wachsenden Inhaltsbedarf zu decken.

Häufig gestellte Fragen

Ja, KI-Stimmen werden zunehmend für Podcasts eingesetzt. Sie eignen sich für Solo-Kommentare, narrative Erzählungen, mehrsprachige Episoden und alle Inhalte, bei denen eine konstante Stimmqualität wichtig ist.

Ja, die meisten KI-Stimmen-Tools erlauben die kommerzielle Nutzung mit kostenpflichtigen Abonnements. Überprüfen Sie immer die spezifischen Lizenzbedingungen jeder Plattform und geben Sie an, wenn Sie KI-generierte Stimmen in Ihren Inhalten verwenden.

Viele KI-Stimmen-Tools bieten neben der Stimmerzeugung auch Transkriptionsfunktionen an. Sie können auch spezielle Transkriptionsdienste nutzen oder Ihre KI-generierten Audioinhalte mit Spracherkennungstools wieder in Text umwandeln.

Exportieren Sie im WAV-Format mit 44,1 kHz/16-Bit für die Bearbeitung und konvertieren Sie dann für die Verbreitung in MP3 mit 128 kbps oder höher.