Im sich schnell entwickelnden Bereich der Inhaltserstellung haben AI Sprachsynthese-Tools für die natürliche Spracherzeugung neue Möglichkeiten für die Art und Weise eröffnet, wie das Publikum Audio konsumiert. Dieser Wandel bietet mehr als nur Komfort – die heutige AI Text-to-Speech-Software verwandelt nicht nur geschriebene Inhalte in lebensechte Stimmen, sondern bietet Entwicklern auch Anpassungsfähigkeit, Emotionen und sprachliche Genauigkeit.

Von Brand Storytelling bis hin zu interaktivem E-Learning – der Einfluss von Technologien zur Sprachgenerierung nimmt weiter zu. Die Entscheidung für die perfekte Sprachsynthesetechnologie ist für alle, die eine ansprechende, qualitativ hochwertige Audioausgabe suchen, die in Geschäfts-, Bildungs- oder Kreativprojekten Aufmerksamkeit erregt, von entscheidender Bedeutung.

AI Sprachsynthese-Technologie verstehen

Die Landschaft der Sprachsynthese hat sich mit dem Aufkommen von künstlicher Intelligenz und natürlicher Sprachverarbeitung dramatisch weiterentwickelt. Bevor Sie sich mit bestimmten Tools befassen, ist es wichtig, die Technologie zu verstehen, die diesen Lösungen zugrunde liegt.

Funktionsweise der AI Sprachgenerierung

Moderne AI Sprachsynthese kombiniert Deep-Learning-Algorithmen mit natürlicher Sprachverarbeitung, um menschenähnliche Stimmen zu erzeugen. Im Gegensatz zu herkömmlichen Text-to-Speech-Konverter-Systemen, die sich auf vorab aufgezeichnete Phoneme stützten, analysieren die heutigen AI -gestützten Lösungen riesige Mengen an Sprachdaten, um natürlich klingende Sprachmuster zu erzeugen, einschließlich der richtigen Intonation, Betonung und emotionalen Nuancen.

Hauptmerkmale der modernen Sprachsynthese

Die heutigen AI Sprachgenerator-Plattformen bieten ausgefeilte Funktionen, die sie für verschiedene Anwendungen von unschätzbarem Wert machen. Zu diesen Funktionen gehören Sprachgenerierung in Echtzeit, Emotionskontrolle und Unterstützung mehrerer Sprachen. Die Technologie der Sprachsynthese ist so weit fortgeschritten, dass die erzeugten Stimmen über lange Passagen hinweg konsistent bleiben und sich gleichzeitig an unterschiedliche Kontexte und Töne anpassen können.

Vorteile der AI Voice-Generierung

AI Sprachsynthese bietet zahlreiche Vorteile für Unternehmen und Content-Ersteller:

- Kostengünstige Alternative zu professionellen Synchronsprechern: Sparen Sie Tausende von Dollar bei Sprechern und behalten Sie gleichzeitig die professionelle Qualität Ihrer Inhalte bei.

- Konsistente Sprachqualität über mehrere Projekte hinweg : Stellen Sie sicher, dass Ihre Markenstimme über alle Inhalte hinweg identisch bleibt, unabhängig von Länge oder Häufigkeit.

- Schnelle Erstellung und Iteration von Inhalten: Generieren Sie Sprachinhalte in Minuten statt in Tagen, was schnelle Überarbeitungen und Aktualisierungen bei Bedarf ermöglicht.

- Skalierbare Lösungen für mehrere Sprachen: Erweitern Sie Ihre Reichweite weltweit, ohne mehrere Synchronsprecher für verschiedene Sprachen einstellen zu müssen.

- Verbesserungen der Barrierefreiheit für digitale Inhalte : Machen Sie Ihre Inhalte für sehbehinderte Benutzer und diejenigen, die Audiokonsum bevorzugen, zugänglich.

Wesentliche Funktionen von Sprachsynthese-Tools

Bei der Bewertung AI Text-to-Speech-Software bestimmen mehrere Schlüsselmerkmale ihre Effektivität und Benutzerfreundlichkeit.

Stimmqualität und Natürlichkeit

Der wichtigste Aspekt jeder Sprachgenerierungssoftware ist die Qualität und Natürlichkeit der erzeugten Stimme. Moderne Systeme sollten Sprache erzeugen, die menschenähnlich klingt, mit angemessenem Tempo, Intonation und emotionaler Resonanz. Dazu gehört der Umgang mit komplexen sprachlichen Elementen wie Redewendungen und kontextabhängiger Aussprache.

Sprachliche Unterstützung

Globale Reichweite erfordert eine umfassende Sprachunterstützung. Die beste Software zum Klonen von Stimmen bietet mehrere Sprachen und regionale Akzente, um sicherzustellen, dass Inhalte ein breites Publikum effektiv erreichen können. Dazu gehören nicht nur die Übersetzungsfähigkeiten, sondern auch die kulturelle Adaption von Sprachmustern und Intonationen.

Anpassungsoptionen

Die Flexibilität bei der Sprachanpassung ermöglicht es Entwicklern, ihre Markenstimme oder spezifische Projektanforderungen anzupassen. Dazu gehören:

- Auswahl des Stimmstils: Wählen Sie aus einer Reihe von Stimmpersönlichkeiten, die zu Ihrem Markenton und den Vorlieben Ihrer Zielgruppe passen.

- Einstellung von Tonhöhe und Geschwindigkeit: Passen Sie die Sprachausgabe an, um das perfekte Tempo und den perfekten Ton für Ihre spezifischen Inhaltsanforderungen zu erstellen.

- Schwerpunkt-Steuerung: Heben Sie Schlüsselbotschaften hervor, indem Sie die Wortbetonung und die Satzbetonungsmuster anpassen.

- Manipulation von Emotionen: Verleihen Sie Ihren Inhalten emotionale Tiefe, indem Sie geeignete Stimmungs- und Toneinstellungen auswählen.

- Benutzerdefinierte Ausspracheregeln: Stellen Sie sicher, dass branchenspezifische Begriffe und Markennamen richtig ausgesprochen werden.

Kompatibilität von Dateiformaten

Professionelle Tools zur Sprachgenerierung AI sollten verschiedene Ein- und Ausgabeformate unterstützen und damit für unterschiedliche Anwendungsfälle und Workflows vielseitig einsetzbar sein.

Top AI Sprachsynthese-Tools für 2025

Schauen wir uns die führenden AI Voice-Over-Generatorlösungen auf dem Markt an und vergleichen wir ihre Funktionen, Fähigkeiten und Anwendungsfälle.

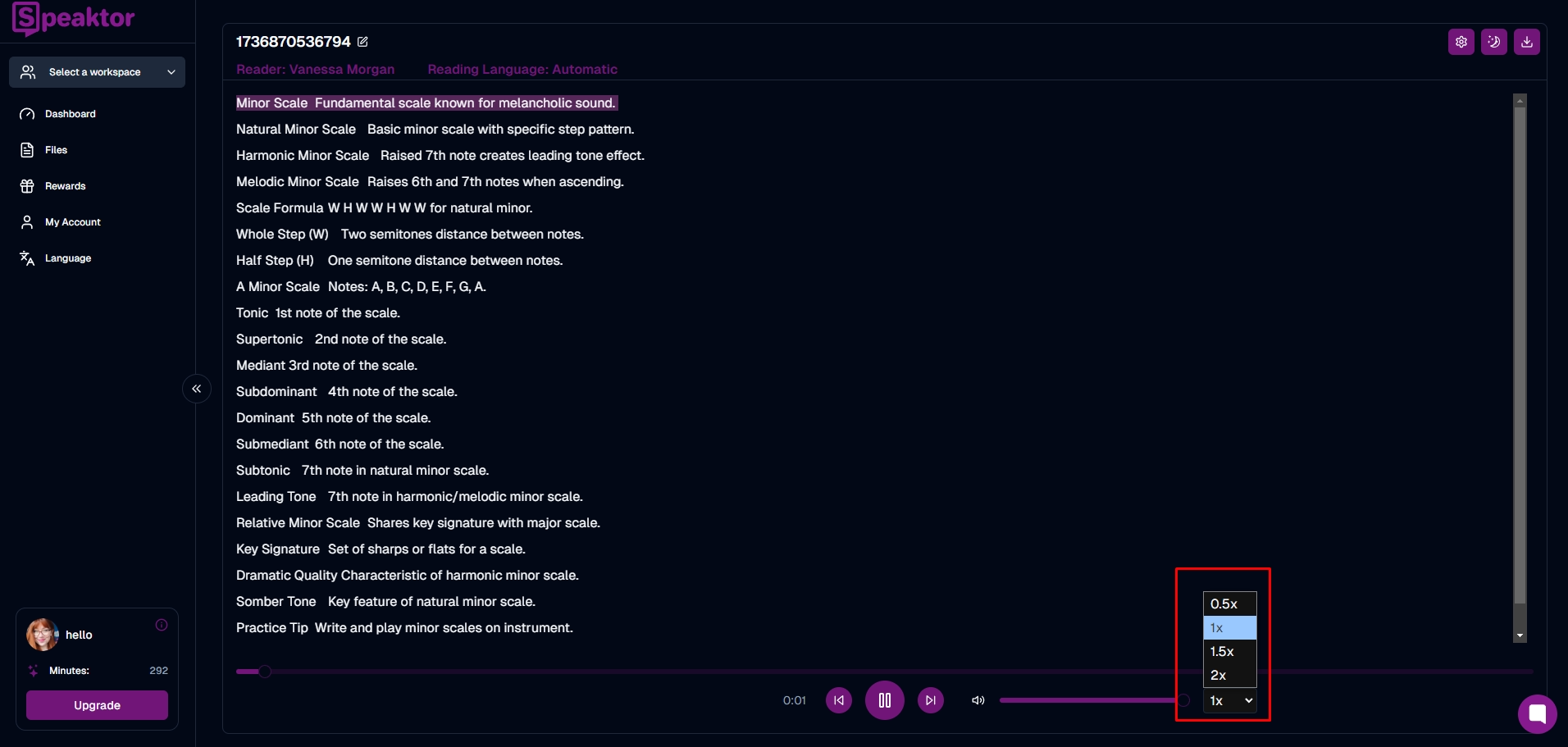

1. Speaktor

Speaktor wurde für Einzelpersonen, Fachleute und große Unternehmen entwickelt, die eine umfassende Lösung für die Sprachsynthese suchen. Es nutzt fortschrittliche AI Sprachassistentenfunktionen, um klares, dynamisches Audio zu erzeugen, das für alles geeignet ist, von einfachen Erzählungen bis hin zu umfassenden Unternehmensmedien. Mit ausgeklügelten Funktionen zeichnet sich Speaktor durch seinen anpassungsfähigen Ansatz zur natürlichen Stimmerzeugung aus.

- Über 50 Sprachen : Unterstützt eine breite Palette von Akzenten und Dialekten, die den unterschiedlichen Bedürfnissen des Publikums gerecht werden.

- Sichere Arbeitsplatzorganisation : Gewährleistet die Zusammenarbeit im Team und die Dateiverwaltung unter strengen Datenschutzstandards.

- Mehrere Ausgabeformate : Enthält MP3 und WAV Optionen für verschiedene Vertriebskanäle.

- Professionelle Voiceover-Erstellung : Bietet mehrere Sprecheroptionen und einstellbare Sprachparameter für qualitativ hochwertige Erzählungen.

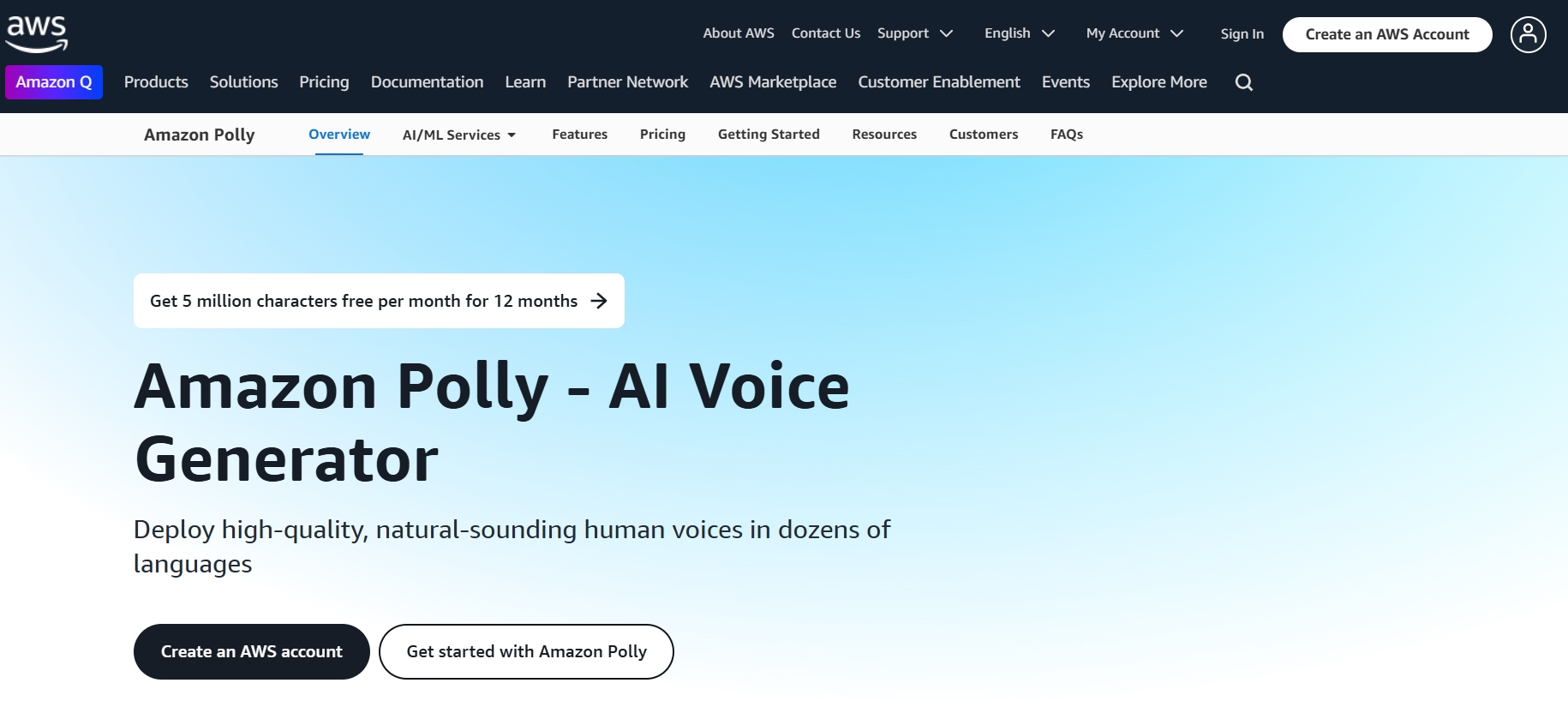

2. Amazon Polly

Amazon Polly nutzt die AWS-Infrastruktur für eine leistungsstarke und skalierbare AI die Sprachgenerierung. Die neuronale Text-to-Speech-Engine erzeugt glaubwürdige Sprachmuster, die sich an verschiedene Kontexte anpassen, ein Vorteil für Unternehmen, die ihre Inhaltsbibliothek erweitern.

Während SSML Unterstützung eine detaillierte Sprachsteuerung ermöglicht, kann ein technischer Hintergrund erforderlich sein, um die Funktionen von Polly voll ausschöpfen zu können. Das Pay-as-you-go-Modell eignet sich für Unternehmen, die mit schwankenden Anforderungen rechnen, und ermöglicht es ihnen, die Nutzung zu erweitern, ohne hohe Vorabkosten zu verursachen.

3. Google Cloud Text-to-Speech

Die Plattform von Google basiert auf WaveNet -basierter Technologie, die sanfte und natürlich klingende Stimmen in zahlreichen Sprachen und Akzenten liefert. Es fügt sich nahtlos in das breitere Google Cloud -Ökosystem ein und ist damit eine gute Wahl für diejenigen, die bereits in die Tool-Suite von Google investiert haben.

Dennoch kann das entwicklerorientierte Design des Dienstes für Neueinsteiger ohne technischen Hintergrund eine Herausforderung darstellen. Jeder, der erweiterte Anpassungen oder eine groß angelegte Bereitstellung sucht, wird die tiefgreifenden Integrationsmöglichkeiten vorteilhaft finden, aber in der Regel auf Kosten einer steileren Lernkurve.

4. Microsoft Azure Rede

Microsoft Azure Speech Services kombiniert neuronale TTS mit Cloud-Sicherheit der Enterprise-Klasse. Die Möglichkeit, benutzerdefinierte Stimmen zu trainieren, hebt es von anderen ab und ermöglicht es Marken, konsistente Stimmidentitäten in Marketing-, Support- und Schulungsmaterialien aufrechtzuerhalten.

Unternehmen, die bereits mit dem Microsoft -Ökosystem verbunden sind, profitieren oft von einer einfachen Produktintegration, die durch Echtzeit-Synthese für Chatbots oder Live-Anwendungen verbessert wird. Trotz der robusten Funktionen kann die Einrichtung für kleinere Unternehmen mit minimaler Microsoft Infrastruktur vergleichsweise komplex sein.

5. Murf AI

Murf AI konzentriert sich auf die unkomplizierte Sprachgenerierung für Kreativteams und Freiberufler. Die übersichtliche Benutzeroberfläche und der integrierte Editor der Plattform ermöglichen es den Nutzern, Audioinhalte zu produzieren und zu optimieren, ohne zwischen mehreren Tools wechseln zu müssen.

Das herausragende Angebot ist das Klonen von Stimmen, bei dem vorhandene stimmliche Merkmale für die kommerzielle Nutzung repliziert werden. Obwohl es möglicherweise nicht die tiefere Unternehmensintegration bietet, die bei größeren Plattformen zu finden ist, ist Murf aufgrund des benutzerfreundlichen Designs und der Schnellstartvorlagen für schnelllebige Produktionsumgebungen beliebt.

Die Wahl des richtigen Sprachsynthese-Tools

Die Auswahl des am besten geeigneten Tools zur Sprachgenerierung AI erfordert ein klares Verständnis Ihrer Content-Ziele, Ihrer technischen Umgebung und Ihrer Budgetbeschränkungen. Die Bewertung von Faktoren wie Sprachabdeckung und Integrationsanforderungen stellt sicher, dass die von Ihnen gewählte Plattform sowohl den unmittelbaren Anforderungen als auch dem zukünftigen Wachstum entspricht. Im Folgenden finden Sie die wichtigsten Überlegungen und Anwendungsszenarien, die eine fundierte Entscheidung leiten.

Schritt 1: Klären Sie Ihre Anforderungen an die Sprachqualität

Wenn Sie den erforderlichen Grad an Realismus oder Ausdruckskraft definieren, können Sie die Liste der AI Text-to-Speech-Lösungen eingrenzen. Einfache Ansagen benötigen möglicherweise nur grundlegende Klarheit, während emotional getriebene Marketingkampagnen sehr natürliche Stimmen mit nuancierter Intonation erfordern.

- Überlegen Sie, ob Sie ausdrucksstarke Funktionen wie Tonanpassungen oder emotionale Beugungen benötigen

- Entscheiden Sie, ob eine spezielle Sprache (z. B. Corporate, Casual) oder ein markenspezifischer Stil obligatorisch ist

- Beachten Sie alle vorhandenen Markenrichtlinien, die den Ton oder die Persona für die Sprachausgabe definieren

Schritt 2: Evaluieren der mehrsprachigen Funktionen

Mehrere Sprachen oder Dialekte können eine Priorität sein, wenn Sie ein internationales oder vielfältiges Publikum bedienen. Tools, die eine kulturelle Anpassung ermöglichen – die über die einfache Übersetzung hinausgehen – können zu authentischeren Ergebnissen führen.

- Überprüfen Sie, ob jede Sprache lokalisierte Akzente und Sprachmuster enthält.

- Stellen Sie sicher, dass die Rechte zum Exportieren oder Verwenden von Dateien für alle unterstützten Sprachen gelten.

- Schauen Sie sich erweiterte Funktionen (wie idiomatische Ausdrücke) für eine nuancierte Zielgruppenansprache an

Schritt 3: Bewerten Sie die technischen Fähigkeiten des Teams

Wählen Sie eine Lösung, die auf das Fachwissen Ihrer Mitarbeiter abgestimmt ist. Einige Plattformen bieten benutzerfreundliche Dashboards, während andere auf APIs oder Skripte setzen und eher technisch versierte Teams ansprechen.

- Bestätigen, ob Entwickler für die Integration erweiterter APIs verfügbar sind

- Entscheiden Sie sich für "No-Code"-Lösungen, wenn Ihnen der technische Hintergrund fehlt

- Berücksichtigen Sie potenzielle Schulungs- oder Onboarding-Zeit, um das Tool vollständig zu nutzen

Schritt 4: Stellen Sie eine reibungslose Workflow-Integration sicher

Ein Sprachsynthese-Tool sollte bestehende Prozesse ergänzen, anstatt sie zu stören. Achten Sie auf eine solide Kompatibilität mit Content-Management-Systemen, Design-Tools oder Projektsoftware.

- Ermitteln Sie, ob die Massenverarbeitung oder Batch-Uploads zu Ihrem Produktionszyklus passen

- Suchen Sie nach integrierten Plugins oder Add-ons, die Ihren aktuellen Software-Stack unterstützen

- Bestätigen, wie gut die Lösung die Planung oder die automatisierte Generierung beherrscht

Schritt 5: Berücksichtigen Sie Budgetbeschränkungen und Skalierbarkeit

Die Balance zwischen Kosten und potenzieller Expansion hilft, zu hohe oder zu geringe Ausgaben zu vermeiden. Vergleichen Sie Pay-per-Character-Modelle, monatliche Abonnements und Jahrespläne, um zu sehen, welche Struktur zu Ihrem Produktionsvolumen passt.

- Informieren Sie sich über mögliche versteckte Kosten, wie z. B. API Anrufe oder benutzerdefinierte Sprachschulungen

- Erkundigen Sie sich nach Rabatten oder Stufen-Upgrades für die Skalierung der Nutzung

- Planen Sie Nachfragespitzen oder saisonale Content-Spitzen

Schritt 6: Passen Sie das Tool an Ihre Anwendungsfälle an

Verschiedene Lösungen zur Sprachsynthese eignen sich für unterschiedliche Szenarien, unabhängig davon, ob es sich um Unternehmen, Bildungseinrichtungen oder Marketing handelt. Ermitteln Sie die Funktionen, die direkt auf Ihr primäres Ziel ausgerichtet sind.

- Prüfen Sie, ob das Tool die Konsistenz der Markenstimme für Werbematerialien unterstützt

- Stellen Sie sicher, dass die Stimme klar ist, wenn die Inhalte in erster Linie pädagogisch sind

- Bewerten Sie emotionale Bandbreite und Authentizität für kreative Storytelling-Zwecke

Implementieren der Sprachsynthese in Ihren Workflow

So maximieren Sie die Vorteile AI Text-to-Speech-Software:

- Beginnen Sie mit klaren Sprachrichtlinien: Erstellen Sie einen umfassenden Voice-Styleguide, der Ton-, Tempo- und Aussprachestandards für Konsistenz definiert.

- Etablieren Sie Qualitätskontrollprozesse: Führen Sie regelmäßige Kontrollen durch, um sicherzustellen, dass alle generierten Inhalte Ihren Qualitätsstandards entsprechen.

- Erstellen Sie konsistente Workflows : Entwickeln Sie standardisierte Verfahren für die Erstellung, Überprüfung und Bereitstellung von Inhalten in Teams.

- Planen Sie die Skalierbarkeit: Entwerfen Sie Ihre Implementierung so, dass sie ein erhöhtes Volumen und zusätzliche Sprachanforderungen bewältigen kann, wenn Ihre Anforderungen wachsen.

- Überwachen Sie die Nutzung und Leistung: Verfolgen Sie wichtige Kennzahlen wie Generierungszeit, Qualitätskonsistenz und Benutzerfeedback, um Ihre Strategie für Sprachinhalte zu optimieren.

Häufige Fallstricke, die bei der Implementierung der Sprachsynthese vermieden werden sollten

Achten Sie auf diese häufigen Herausforderungen:

- Übersehen der Anpassung der Aussprache : Stellen Sie sicher, dass branchenspezifische Begriffe richtig ausgesprochen werden, indem Sie benutzerdefinierte Wörterbücher und Ausspracheregeln einrichten.

- Ignorieren der Dateiformatanforderungen: Überprüfen Sie die Kompatibilität mit Ihren Zielplattformen und legen Sie klare Richtlinien für Dateiformate und Qualitätseinstellungen fest.

- Unterschätzung der Bearbeitungszeit: Berücksichtigen Sie die Verarbeitungszeit in Ihrer Zeitleiste für die Erstellung von Inhalten, insbesondere für die Stapelverarbeitung und lange Inhalte.

- Vernachlässigung von Backup-Lösungen: Implementieren Sie robuste Backup-Systeme und Notfallpläne für kritische Anforderungen an die Generierung von Sprachinhalten.

- Unzureichende Tests auf allen Plattformen: Führen Sie gründliche Tests auf allen Zielgeräten und -plattformen durch, um eine gleichbleibende Qualität und Leistung zu gewährleisten.

Schlussfolgerung

AI Sprachsynthese-Tools haben die Erstellung von Sprachinhalten revolutioniert und bieten eine noch nie dagewesene Qualität und Effizienz. Während jede Plattform ihre Stärken hat, entpuppt sich Speaktor als umfassende Spracherkennungstechnologielösung, die fortschrittliche Funktionen mit benutzerfreundlicher Bedienung in Einklang bringt. Seine Kombination aus natürlicher Sprachqualität, umfangreicher Sprachunterstützung und robuster Arbeitsbereichsorganisation macht es zu einer ausgezeichneten Wahl für Unternehmen, die professionelle Sprachsynthesefunktionen suchen.

Machen Sie den nächsten Schritt auf Ihrem Weg zur Erstellung von Sprachinhalten, indem Sie herausfinden, was Speaktor für Ihre spezifischen Anforderungen tun können. Mit den Funktionen der Enterprise-Klasse und der intuitiven Benutzeroberfläche können Sie mit der Produktion hochwertiger Sprachinhalte beginnen, die Ihr Publikum effektiv ansprechen.