Generator głosów celebrytów: Ryzyka, regulacje i odpowiedzialne alternatywy

Spis treści

- Jak działają generatory głosów celebrytów oparte na AI?

- Jakie są typowe zagrożenia związane z generowaniem głosów celebrytów?

- Regulacje branżowe dotyczące klonowania głosów celebrytów

- Jak postępować z generatorami głosów celebrytów?

- Jakie są odpowiedzialne zastosowania AI głosu?

- Bezpieczniejsza alternatywa dla generatorów głosów celebrytów

- Wybierz etyczną ścieżkę z narzędziami głosowymi AI

Transcribe, Translate & Summarize in Seconds

Spis treści

- Jak działają generatory głosów celebrytów oparte na AI?

- Jakie są typowe zagrożenia związane z generowaniem głosów celebrytów?

- Regulacje branżowe dotyczące klonowania głosów celebrytów

- Jak postępować z generatorami głosów celebrytów?

- Jakie są odpowiedzialne zastosowania AI głosu?

- Bezpieczniejsza alternatywa dla generatorów głosów celebrytów

- Wybierz etyczną ścieżkę z narzędziami głosowymi AI

Transcribe, Translate & Summarize in Seconds

TL;DR

Narzędzia do generowania głosów celebrytów są kreatywne, ale niosą ze sobą poważne ryzyko, takie jak oszustwa, dezinformacja, szkody wizerunkowe i spory prawne

Organy regulacyjne na całym świecie szybko działają, aby chronić głosy jako część tożsamości osobistej

Odpowiedzialne zastosowania sztucznej inteligencji głosowej obejmują dostępność (przywracanie utraconej mowy), lokalizację (treści w wielu językach) i kreatywne media (opowiadanie historii, edukacja, parodia)

Bezpieczniejszym wyborem jest unikanie klonowania prawdziwych osób i wybór platform takich jak Speaktor, które zapewniają naturalnie brzmiące syntetyczne głosy w ponad 50 językach bez ryzyka prawnego czy etycznego

Generatory głosów celebrytów zyskały ogromną popularność, pozwalając każdemu sprawić, by gwiazda popu prowadziła podcast lub znany aktor opowiedział żart w czacie grupowym.

Na pierwszy rzut oka narzędzie wydaje się zabawne i innowacyjne. Jednak pod powierzchnią technologia ta rodzi trudne pytania dotyczące prywatności, legalności i etyki.

Narzędzia do generowania głosów celebrytów opierają się na zaawansowanych modelach AI, które potrafią naśladować ton, kadencję i osobowość z niesamowitą dokładnością. Otwiera to drzwi do kreatywnych zastosowań, takich jak dubbing filmów w wielu językach, tworzenie bardziej angażujących audiobooków lub zapewnienie osobom z utratą mowy nowych sposobów komunikacji.

Istnieje jednak ciemniejsza strona: sklonowane głosy są już wykorzystywane jako broń w oszustwach, kampaniach dezinformacyjnych i nielicencjonowanych poparciach. Dla celebrytów to bezpośrednie zagrożenie dla reputacji i dochodów. Dla branż takich jak media, rozrywka i bankowość to wyzwanie regulacyjne i dotyczące zaufania.

Jak działają generatory głosów celebrytów oparte na AI?

W swojej istocie generator głosów celebrytów opiera się na syntezie mowy wspomaganej przez AI. Wykorzystują one prawdziwe nagrania głosu danej osoby i trenują sieci neuronowe do naśladowania ich unikalnych wzorców.

Proces ten obejmuje dwa kluczowe komponenty:

- Modele klonowania głosu: Modele głębokiego uczenia analizują charakterystykę głosową danej osoby, taką jak wysokość, ton, rytm i akcent. Przy wystarczającej liczbie próbek system tworzy cyfrowy odcisk głosu, który oddaje istotę sposobu mówienia tej osoby.

- Silniki text-to-speech (TTS) lub speech-to-speech: Gdy model nauczy się głosu, może generować nowe audio. Możesz wpisać tekst (TTS) lub dostarczyć własny głos (speech-to-speech), a AI odtworzy go w sklonowanym głosie celebryty.

Nowoczesne systemy potrafią nawet uchwycić emocje i intonację, aby wygenerowany dźwięk brzmiał bardziej autentycznie niż robotycznie. Ponieważ trenowanie i renderowanie często odbywa się w chmurze, każdy z przyjazną dla użytkownika aplikacją może w ciągu kilku minut stworzyć audio brzmiące jak głos celebryty.

Jakie są typowe zagrożenia związane z generowaniem głosów celebrytów?

1. Oszustwa i cyberprzestępstwa

W głośnej sprawie z 2024 roku pracownik międzynarodowej firmy został oszukany i przelał ponad 25 milionów dolarów w wyniku deepfake'owej rozmowy wideo z sklonowanym CFO. Fałszywe połączenia alarmowe lub sklonowane głosy są wykorzystywane do oszukiwania ofiar, aby przekazały pieniądze lub poufne informacje. Takie ataki są trudniejsze do wykrycia niż tradycyjny phishing, ponieważ brzmią autentycznie.

2. Bitwy prawne

Głos osoby jest uważany za część jej tożsamości. Używanie go bez zgody może naruszać prawo do wizerunku, prowadząc do pozwów sądowych. W branżach takich jak reklama, gry czy film, nieuprawnione wykorzystanie głosu celebryty może naruszać umowy i prowadzić do kosztownych sporów prawnych.

3. Szkody wizerunkowe

Jeśli sklonowany głos celebryty wydaje się popierać produkt lub opinię, na którą nigdy się nie zgodził, może to podważyć zaufanie zarówno do celebryty, jak i do marki. Dla firm kojarzenie się z nielicencjonowanym klonowaniem głosu może być postrzegane jako nieetyczne i zaszkodzić lojalności klientów.

4. Dezinformacja

Deepfake'i audio ułatwiają rozpowszechnianie fałszywych informacji lub manipulowanie opinią publiczną. Przekonujący fałszywy klip informacyjny lub oświadczenie polityczne w znanym głosie może być szczególnie szkodliwe, ponieważ ludzie mają tendencję do wierzenia w to, co słyszą.

5. Zagrożenia bezpieczeństwa

Między 2024 a 2025 rokiem, oszustwa związane z podszywaniem się pod AI wzrosły alarmująco o 148%. Systemy uwierzytelniania głosu, powszechnie stosowane w bankowości i obsłudze klienta, stały się teraz podatnymi celami. Dzięki sklonowanemu głosowi, atakujący mogą ominąć kontrole tożsamości i uzyskać dostęp do wrażliwych kont.

Regulacje branżowe dotyczące klonowania głosów celebrytów

Stany Zjednoczone

- ELVIS Act z Tennessee (2024): Pierwsze prawo w USA wyraźnie chroniące głosy artystów przed niewłaściwym użyciem AI. Nieautoryzowane klonowanie staje się przestępstwem, a prawo zostało wprowadzone z mocnym poparciem wytwórni muzycznych i związków artystów.

- NO FAKES Act (do ponownego wprowadzenia w 2025): Dwupartyjny projekt ustawy federalnej, który zakazywałby nieautoryzowanych replik AI głosu lub wizerunku osoby. Zawiera wyjątki dla parodii i dziennikarstwa, ale wprowadza proces usuwania, aby ofiary mogły odzyskać kontrolę nad swoją tożsamością.

- TAKE IT DOWN Act (2025): Choć skupia się głównie na niekonsensualnych intymnych obrazach, TAKE IT DOWN Act sygnalizuje, że regulacje dotyczące deepfake'ów są teraz mocno na agendzie Waszyngtonu, tworząc podstawy dla szerszej ochrony.

Europa

- EU AI Act (obowiązuje od 2024): Pierwsze na świecie kompleksowe prawo dotyczące AI. Kategoryzuje technologie deepfake (w tym klonowanie głosu) jako „wysokiego ryzyka” przy użyciu w sposób zwodniczy, wymagając jasnego ujawnienia i surowszej zgodności.

- Proponowane prawo Danii (2025/26): Przełomowa poprawka do prawa autorskiego, która dałaby ludziom wyraźne prawa własności do ich głosu, twarzy i wizerunku. Ofiary nieautoryzowanego klonowania mogłyby żądać usunięcia i odszkodowania. Proponowane prawo mogłoby stać się wzorem dla innych państw UE.

Poza USA i Europą, inne kraje również szybko działają, aby zająć się ryzykiem związanym z klonowaniem głosów celebrytów lub klonowaniem głosów ogólnie.

Od Azji po Amerykę Łacińską, decydenci badają nowe przepisy, które równoważą innowacje z ochroną przed kradzieżą tożsamości i dezinformacją.

Podejścia są różne, ale globalny trend jest jasny: regulatorzy branżowi traktują klonowanie głosów jako kwestię wysokiej stawki, która wymaga jasności prawnej i zabezpieczeń dla jednostek.

Jak postępować z generatorami głosów celebrytów?

- Uzyskaj wyraźną zgodę: Jeśli zamierzasz użyć głosu rzeczywistej osoby, uzyskaj pisemną zgodę od niej lub jej spadkobierców. To najpewniejsze zabezpieczenie przed konsekwencjami prawnymi lub reputacyjnymi.

- Bądź transparentny wobec odbiorców: Zawsze ujawniaj, kiedy głos jest generowany przez AI. Prosty komunikat zwiększa zaufanie i unika postrzegania oszustwa.

- Unikaj obszarów wysokiego ryzyka: Przesłania polityczne, porady zdrowotne, instrukcje finansowe i rekomendacje komercyjne są szczególnie niebezpieczne bez licencji.

- Wybieraj zgodne platformy: Polegaj na narzędziach oferujących znakowanie wodne, dzienniki użycia i funkcje usuwania, pokazując, że poważnie traktują niewłaściwe użycie.

Klonowanie głosów celebrytów może być obarczone ryzykiem, ale sama technologia AI głosu ma znaczące i etyczne zastosowania.

Jakie są odpowiedzialne zastosowania AI głosu?

Dostępność

AI głosu daje osobom, które straciły naturalną mowę, możliwość ponownej komunikacji. Trenując modele na podstawie wcześniejszych nagrań, jednostki mogą zachować lub nawet przywrócić własne głosy. Dla innych, naturalnie brzmiące głosy AI sprawiają, że czytniki ekranowe, urządzenia wspomagające i codzienne interakcje cyfrowe stają się bardziej inkluzywne.

Czy wiesz, że:

Po operacji mózgu, 21-letnia Lexi Bogan straciła zdolność mówienia. Wykorzystując 15-sekundowe nagranie wideo, badacze współpracowali z OpenAI, aby odtworzyć jej nastoletni głos, którego teraz używa poprzez aplikację do komunikacji i wykonywania codziennych zadań.

Lokalizacja

Generatory głosu AI mogą pomóc w skalowaniu treści w różnych językach bez poświęcania ekspresji. Od dubbingowania filmów i programów telewizyjnych po udostępnianie materiałów e-learningowych lub audiobooków na całym świecie, licencjonowane głosy AI sprawiają, że lokalizacja jest szybsza, bardziej przystępna cenowo i angażująca.

Media kreatywne i opowiadanie historii

Artyści, edukatorzy i twórcy eksperymentują z głosami AI do parodii, satyry i immersyjnego opowiadania historii. Gdy odbiorcy są jasno poinformowani, że głosy są syntetyczne, AI może dodać nowe warstwy kreatywności, ożywić historyczne narracje, eksperymentować z głosami postaci lub przesuwać granice sztuki cyfrowej.

Bezpieczniejsza alternatywa dla generatorów głosów celebrytów

Jeśli chcesz czerpać korzyści z głosów AI bez ryzyka prawnego czy etycznego, najbezpieczniejszą opcją jest korzystanie z narzędzi zaprojektowanych z myślą o dostępności i tworzeniu treści, a nie o podszywaniu się.

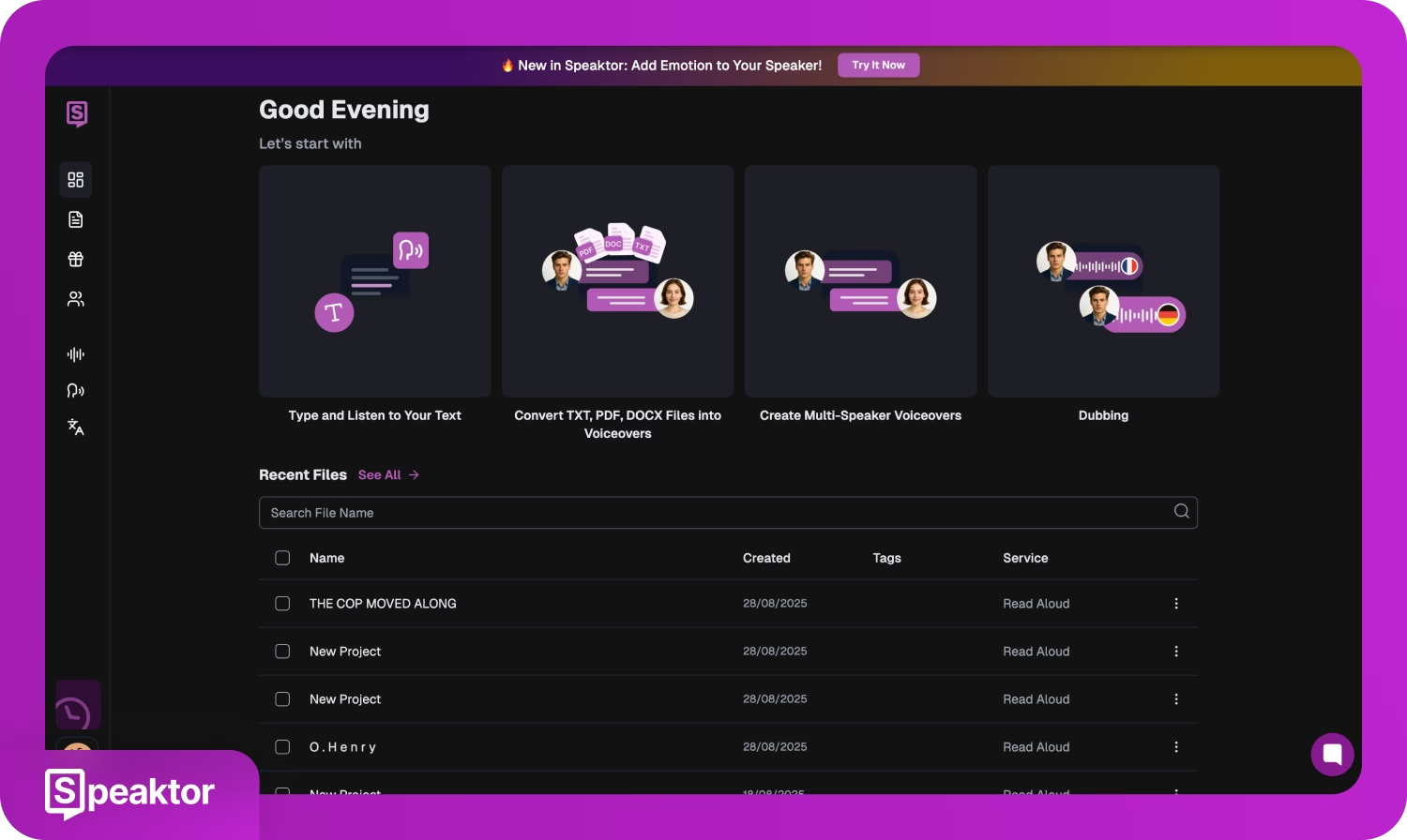

Jedną z takich opcji jest Speaktor. Zamiast klonować prawdziwe osoby, Speaktor oferuje bibliotekę naturalnie brzmiących syntetycznych głosów w wielu językach. Jest szeroko stosowany do tworzenia podkładów głosowych AI, audiobooków, modułów e-learningowych, podcastów, a także do udostępniania treści osobom z trudnościami w czytaniu.

Ponieważ głosy Speaktora nie są powiązane z celebrytami, uzyskujesz zalety technologii głosowej AI: skalowalność, przejrzystość i obsługę wielu języków, bez ryzyka naruszenia praw do tożsamości kogokolwiek.

Oto dlaczego Speaktor wyróżnia się jako aplikacja do podkładów głosowych AI:

- Umożliwia syntezę głosu w ponad 50 językach i dialektach

- Dostarcza realistyczną i ekspresyjną mowę generowaną przez AI

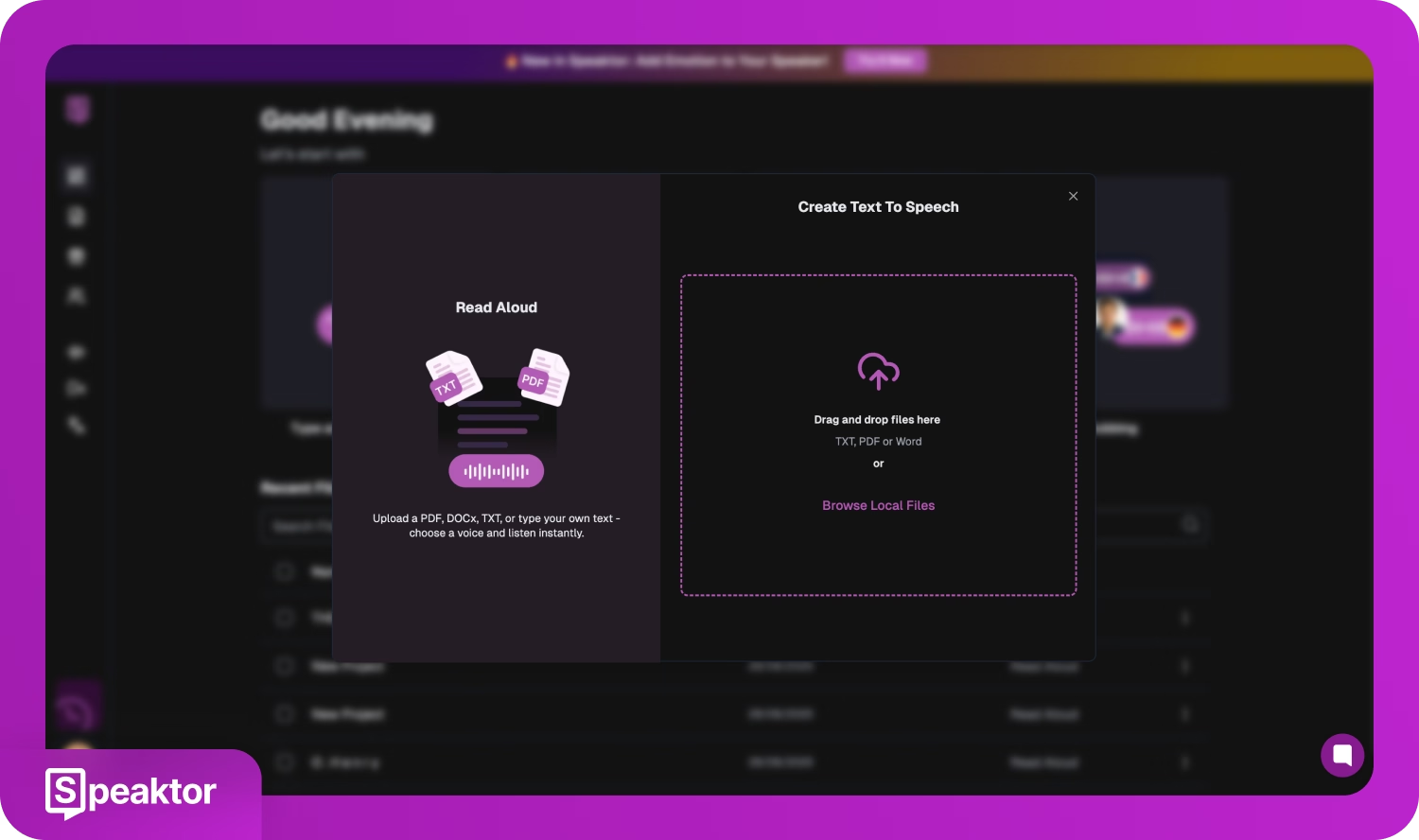

- Pozwala wkleić tekst lub przesłać dokumenty w formatach PDF, TXT lub DOCX

- Oferuje szeroki zakres głosów i ustawień, takich jak ton, styl, emocje i tempo, umożliwiając dostosowanie dźwięku do różnych odbiorców

- Wspiera łatwy eksport dźwięku w formatach MP3 lub WAV

- Wyposażony w intuicyjny panel internetowy i aplikację mobilną; dostępny na komputerach, Androidzie i iOS

Wybierz etyczną ścieżkę z narzędziami głosowymi AI

Generator głosów celebrytów z pewnością wydaje się ekscytujący, ale ryzyko sporów prawnych, szkód wizerunkowych i regulacyjnych często przewyższa nowość.

Bezpieczniejszym wyborem jest unikanie narzędzi naśladujących prawdziwe osoby i poleganie na narzędziach do generowania głosu AI lub oprogramowaniu text-to-speech zaprojektowanym z myślą o dostępności, kreatywności i produkcji treści.

Tu wkraczają platformy takie jak Speaktor. Oferując szeroki zakres naturalnie brzmiących syntetycznych głosów w różnych językach, Speaktor daje korzyści z technologii głosowej AI bez etycznych czy prawnych obaw związanych z klonowaniem.

Jeśli chcesz odpowiedzialnie korzystać z głosów AI, zacznij eksperymentować ze Speaktorem już dziś!

Często zadawane pytania

Nie, chyba że masz wyraźną pisemną zgodę na wykorzystanie głosu celebryty. Używanie głosów celebrytów bez zgody może prowadzić do działań prawnych, uszkodzenia marki, a nawet oszustw. Jeśli Twoim celem jest po prostu przekształcenie tekstu w wysokiej jakości narrację, realistyczny generator głosu AI, taki jak Speaktor, oferuje bezpieczniejszą alternatywę bez podszywania się pod znane osoby.

Modyfikator głosu celebryty naśladuje konkretną osobę, podczas gdy generator głosu AI tworzy syntetyczne głosy niepowiązane z rzeczywistymi tożsamościami. Ten pierwszy budzi obawy dotyczące prywatności i praw autorskich, podczas gdy ten drugi jest zaprojektowany do profesjonalnych nagrań lektorskich, audiobooków lub e-learningu. Dzięki narzędziom takim jak Speaktor możesz generować dźwięk w wielu językach bez przekraczania granic prawnych.

Tak. Generator głosów celebrytów AI może uchwycić wysokość, ton i niuanse językowe ludzkich wzorców mowy. Jednak dokładność nie oznacza pozwolenia. Te systemy mogą naśladować pożądany głos celebryty, ale bezpieczniejszym podejściem jest korzystanie z platform, które tworzą ekspresyjne, ale neutralne głosy AI do projektów kreatywnych.

Tak. Wiele platform oferuje opcję darmowego generatora głosu AI, aby pomóc użytkownikom przetestować funkcje. Speaktor, na przykład, pozwala przekształcić tekst w naturalne wyjścia głosowe AI w wielu językach, dzięki czemu możesz tworzyć nagrania głosowe do filmów szkoleniowych, podcastów, e-booków lub treści w mediach społecznościowych bez polegania na nieautoryzowanych klonach głosów celebrytów AI. Możesz wypróbować go za darmo!

Tak. Dzisiejsza realistyczna technologia głosowa umożliwia osiągnięcie narracji o jakości studyjnej bez naśladowania głosów celebrytów. Na przykład, realistyczny generator głosu AI Speaktor zapewnia ekspresyjne, naturalne pliki audio, które rywalizują z aktorami głosowymi.

Używanie generatora głosów celebrytów AI może przyciągnąć krótkoterminową uwagę, ale naraża również firmy na spory o prawa autorskie, kary regulacyjne i szkody reputacyjne. Marki ryzykują utratę zaufania, jeśli wygenerowany głos zostanie pomylony z rzeczywistym poparciem. Dlatego przedsiębiorstwa często wybierają generatory głosu AI, takie jak Speaktor, które zapewniają skalowalną jakość głosu bez naśladowania unikalnych głosów celebrytów.