Generer livagtig lyd i stor skala med Speaktors AI tekst-til-tale. Denne realistiske stemmegenerator leverer naturligt lydende stemmer og flersproget support – perfekt til at generere voiceovers, konvertere tekst til lyd eller bruge oplæsningsfunktioner.

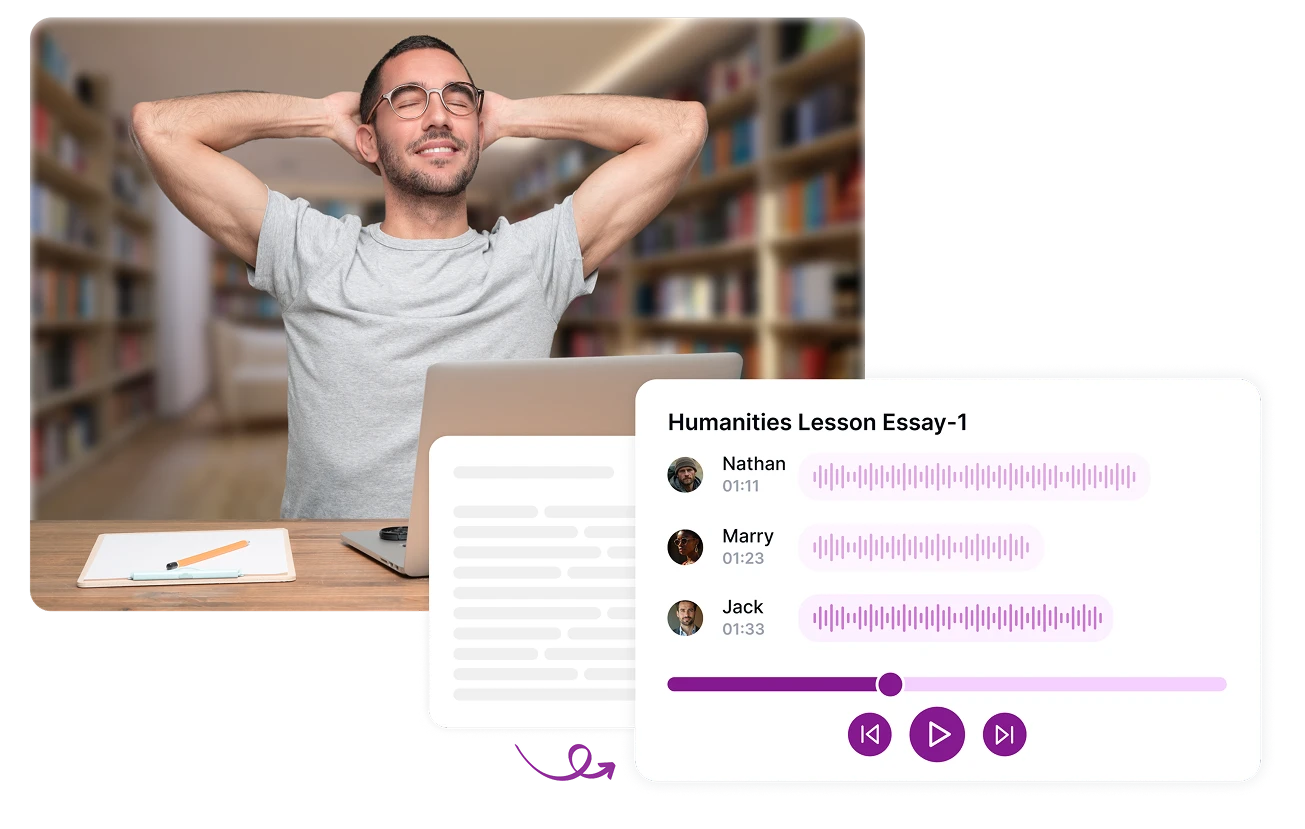

Producér studiokvalitets voiceovers til videoer, præsentationer og podcasts ved hjælp af Speaktors AI-stemmegenerator. Upload dine manuskripter direkte eller importér indhold via Excel for effektiv batch voiceover-oprettelse. Vælg mellem en række realistiske stemmer og flere taleralternativer, hvilket gør det perfekt for skabere, marketingfolk og virksomheder.

Brug Speaktors AI-drevne tekst-til-tale-konverter til at konvertere enhver tekst til lyd og lyt, mens du multitasker. Vælg mellem naturligt lydende stemmer på over 50 sprog til at oplæse artikler, e-mails og dokumenter med lethed.

Skab professionel lyd til enhver platform med Speaktors AI-lydgenerator. Uanset om du producerer YouTube-videoer, deler historier på TikTok, poster på Instagram, udgiver Reels med voiceover eller optager podcasts, hjælper Speaktor dig med øjeblikkeligt at omdanne tekst til brugsklar MP3- eller WAV-filer.

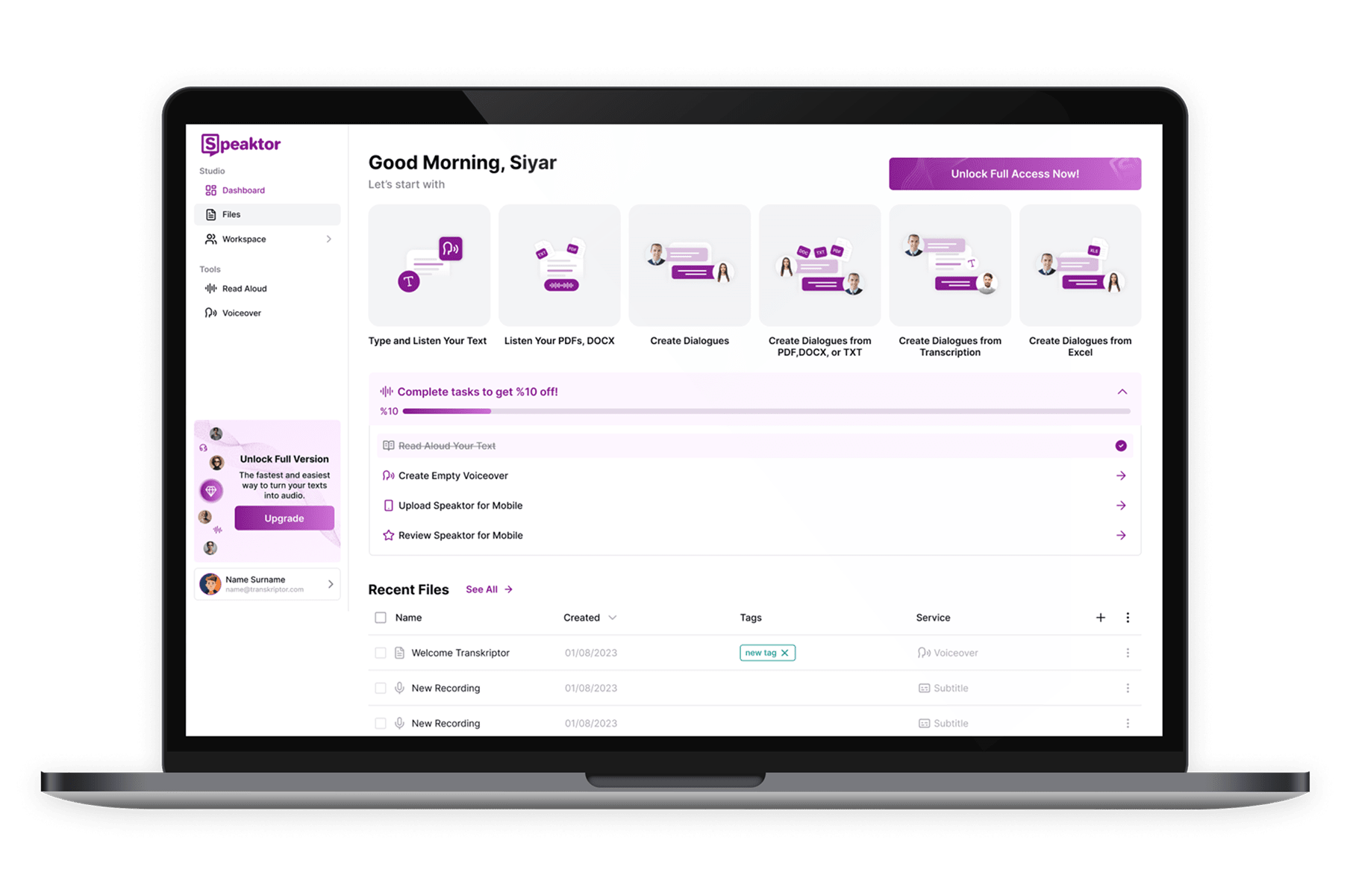

Få adgang til Speaktors AI tekst-til-tale-konverter og stemmegenerator direkte i enhver browser. Perfekt til at skabe voiceovers, lydbøger og marketingmaterialer med tekst-til-tale-teknologi på enhver computer.

Kom i gang på få sekunder uden indlæringskurve. Speaktors AI tekst-til-tale værktøj gør konvertering af tekst til naturligt lydende audio hurtigt, enkelt og ubesværet.

Skab høj-kvalitets AI voiceovers til en brøkdel af prisen for traditionel stemmeoptagelse. Speaktor tilbyder budgetvenlige abonnementer.

Konverter tekst til tale direkte i Speaktor uden ekstra trin. Omdanner øjeblikkeligt ethvert skriftligt indhold til lyd for håndfri lytning når som helst og hvor som helst.

Tekst til tale (TTS) er en teknologi drevet af kunstig intelligens, der konverterer skreven tekst til talt lyd. Det bruges ofte til at lytte til artikler, bøger, manuskripter og andet indhold, hvilket gør det ideelt til multitasking, forbedring af tilgængelighed og skabelse af voiceovers i høj kvalitet.

Tekst til tale fungerer ved at bruge kunstig intelligens til at konvertere skreven tekst til talt lyd. Speaktor bruger avancerede AI-stemmemodeller til at producere naturligt lydende voiceovers fra enhver tekst med bare få klik.

Tekst til tale tilbyder mange fordele, herunder øget tilgængelighed, understøttelse af multitasking, forbedret indlæring og hurtigere indholdsproduktion. Det er ideelt for både studerende, fagfolk og indholdsproducenter.

En AI-voiceover er en syntetisk lydoptagelse genereret af kunstig intelligens fra skreven tekst. Speaktor giver brugerne mulighed for at skabe professionelle voiceovers uden at optage deres egen stemme, hvilket gør indholdsproduktion hurtigere og nemmere.

Tekst til tale bruges af en bred vifte af mennesker, herunder studerende, undervisere, marketingfolk, indholdsproducenter, synshandicappede brugere og virksomheder, der har brug for skalerbart stemmeindhold til træning, medier eller kundesupport.

Moderne AI-voiceovers lyder meget realistiske takket være fremskridt inden for deep learning og talesyntese. Mange værktøjer tilbyder nu stemmer, der efterligner menneskelig tone, følelse og tempo, hvilket gør dem egnede til professionel brug.

Tekst-til-tale henviser til den generelle proces med at konvertere tekst til talt lyd, mens AI-voiceover fokuserer mere på at skabe naturlig, udtryksfuld og produktionsklar lyd til brug i medier, marketing og indhold.

AI-voiceovers kan erstatte menneskelige stemmeskuespillere til mange opgaver som forklaringsvideoer, produktdemoer eller intern træning. Menneskelige stemmetalenter foretrækkes dog stadig til projekter, der kræver følelsesmæssig nuance og præstation.

Ja, det er lovligt at bruge AI-voiceovers, så længe du har ret til at bruge teksten og overholder licensbetingelserne for stemmesoftwaren. Sørg altid for, at indholdet ikke krænker ophavsrettigheder eller udgiver sig for at være rigtige personer.